はじめに

明けましておめでとうございます。

昨年も東芝に暗雲が立ち込め、東証2部に降格して日経平均から外れ、ついには18年3月末にサザエさんからのスポンサー契約を降板する方向で調整とあいなりました。

さて、サザエさんのじゃんけんを長年記録しデータをWebスクレイピングさせて頂いた「サザエさんジャンケン学」が2017年6月25日を以て終了されていました。データを取得した際に7月以降がなかったので、あれっと思って見たらそういうことでした。長い間お疲れ様でしたm(_ _)m

www.asahi-net.or.jp

さてさて、2017年のサザエさんのじゃんけん結果はどうなったでしょう。 ちなみに、2016年のサザエさんのじゃんけん結果は、27勝11敗12分(勝率0.711)でした。

人工知能による予測化を断念

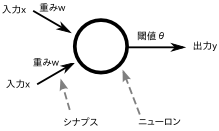

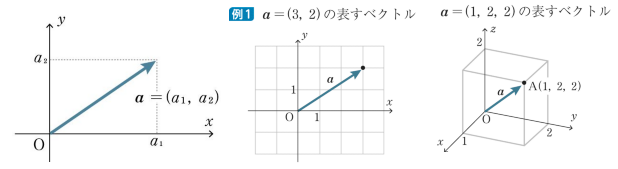

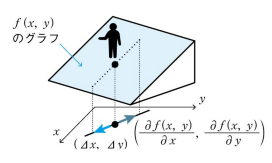

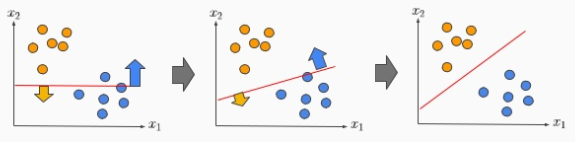

本来はDeepLearningを使用して予想をする予定でしたが、まだ勉強中のままです。あと少しだと思うので今年中にはなんとかなると思います。

昨年、R言語からPythonに切り替えました。

qiita.com

Python使うに際にはいつも Jyupter notebook だったので、この為に久しぶりに Visual Studio Code で Python を実行しようとしてバージョンアップ(1.19.1)したらタスク実行の設定がいろいろ変わって動かなくて、四苦八苦しながらなんとか動かせるようにしました。下記の記事を修正してあります。 yaju3d.hatenablog.jp

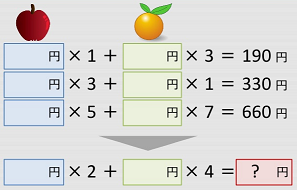

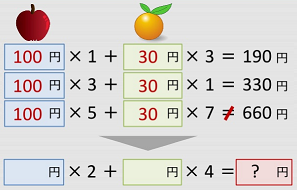

次の手の予測アルゴリズム

- チョキが多いので、グー > チョキ > パーの優先順位とする

- 前回と違う手を出すので、上記の優先順位で勝手を選ぶ

- 二手前と一手前が違う手なら、残りの手を出すので勝手を選ぶ

- 三手の中に同手がある場合、 残りの手を出すので勝手を選ぶ

- 二手前と一手前が同じ手なら、勝手を出すので負手を選ぶ

2017年の勝敗結果

| 年月 | サザエさんの手 | 予想の手 | 勝敗結果 |

|---|---|---|---|

| 01月01日 | 休み | ||

| 01月08日 | チョキ | グー | 勝ち |

| 01月15日 | チョキ | グー | 勝ち |

| 01月22日 | パー | パー | 引き分け |

| 01月29日 | グー | パー | 勝ち |

| 02月05日 | グー | グー | 引き分け |

| 02月12日 | パー | グー | 負け |

| 02月19日 | チョキ | グー | 勝ち |

| 02月26日 | チョキ | パー | 負け |

| 03月05日 | グー | パー | 勝ち |

| 03月12日 | パー | チョキ | 勝ち |

| 03月19日 | 休み | ||

| 03月26日 | チョキ | グー | 勝ち |

| 04月02日 | チョキ | パー | 負け |

| 04月09日 | グー | パー | 勝ち |

| 04月16日 | パー | チョキ | 勝ち |

| 04月23日 | パー | グー | 負け |

| 04月30日 | チョキ | グー | 勝ち |

| 05月07日 | グー | パー | 勝ち |

| 05月14日 | パー | チョキ | 勝ち |

| 05月21日 | チョキ | グー | 勝ち |

| 05月28日 | グー | パー | 勝ち |

| 06月04日 | チョキ | チョキ | 引き分け |

| 06月11日 | パー | チョキ | 勝ち |

| 06月18日 | グー | パー | 勝ち |

| 06月25日 | グー | グー | 引き分け |

| 07月02日 | チョキ | グー | 勝ち |

| 07月09日 | パー | チョキ | 勝ち |

| 07月16日 | グー | パー | 勝ち |

| 07月23日 | パー | グー | 負け |

| 07月30日 | チョキ | グー | 勝ち |

| 08月06日 | パー | パー | 引き分け |

| 08月13日 | グー | パー | 勝ち |

| 08月20日 | チョキ | グー | 勝ち |

| 08月27日 | グー | チョキ | 負け |

| 09月03日 | パー | チョキ | 勝ち |

| 09月10日 | パー | グー | 負け |

| 09月17日 | チョキ | グー | 勝ち |

| 09月24日 | グー | パー | 勝ち |

| 10月01日 | チョキ | チョキ | 引き分け |

| 10月15日 | パー | チョキ | 勝ち |

| 10月22日 | グー | パー | 勝ち |

| 10月29日 | 休み | ||

| 11月05日 | チョキ | グー | 勝ち |

| 11月12日 | チョキ | チョキ | 引き分け |

| 11月19日 | グー | チョキ | 負け |

| 11月26日 | パー | チョキ | 勝ち |

| 12月03日 | パー | グー | 負け |

| 12月10日 | チョキ | グー | 勝ち |

| 12月17日 | グー | パー | 勝ち |

| 12月24日 | パー | チョキ | 勝ち |

結果は、32勝9敗7分(勝率0.780)となりました。

ちなみに、サザエさんじゃんけん研究所 公式ウェブサイトの サザエさんの手の予想と勝負結果(2017年)が29勝8敗11分(勝率0.783)でした。

今回は勝数では上回ったのですが、勝率では僅差で負けました。 勝率の計算は、「勝ち / (勝ち + 負け)」で行っているのですが、負けの1つが響いたわけです。

【2017/01/09追記】

2017年冬版 サザエさんじゃんけん白書によるとクール(四半期)の初回(1月、4月、7月、10月の初回)はチョキが出やすいとのことです。もし、これを取り入れた場合、04月02日(負け)と10月01日(引き分け)なので、34勝8敗6分(勝率0.809)になるかな。

| 年 | データ分析 | 研究所公式 |

|---|---|---|

| 2013 | 24勝13敗12分(勝率0.649) | 25勝9敗17分(勝率0.735) |

| 2014 | 30勝10敗11分(勝率0.750) | 30勝9敗12分(勝率0.769) |

| 2015 | 32勝9敗9分(勝率0.780) | 33勝9敗8分(勝率0.785) |

| 2016 | 27勝11敗12分(勝率0.711) | 22勝13敗15分(勝率0.628) |

| 2017 | 32勝9敗7分(勝率0.780) | 29勝8敗11分(勝率0.783) |

スライド

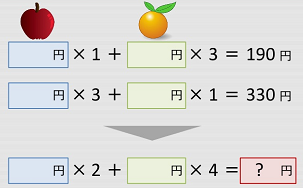

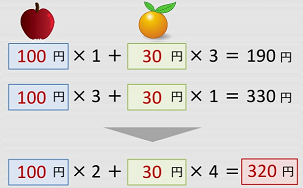

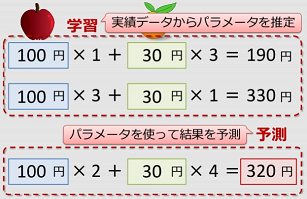

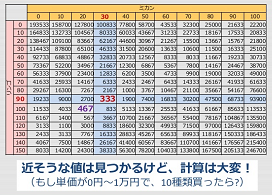

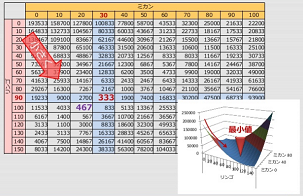

2013年に静岡Developers勉強会で機械学習を学び、2014年1月にネタとしてSlideShareに公開しました。

最後に

今年中にはTensorFlowを使って人工知能のディープラーニングで予測手を作りたいと思います。まだ組むだけの理解度(n-gramモデル)が足りないためですが、あと少しで理解度が進むはずです。

【2018/01/07 追記】

r_stdさんが、機械学習を用いて検証してくれました。2016年に統計検定準1級に合格している方で幾つかの手法を使っています。その中で、naive bayesで33勝9敗6分と好成績を残しています。タイトルが①なので次回も期待しています。

r-std.hatenablog.com